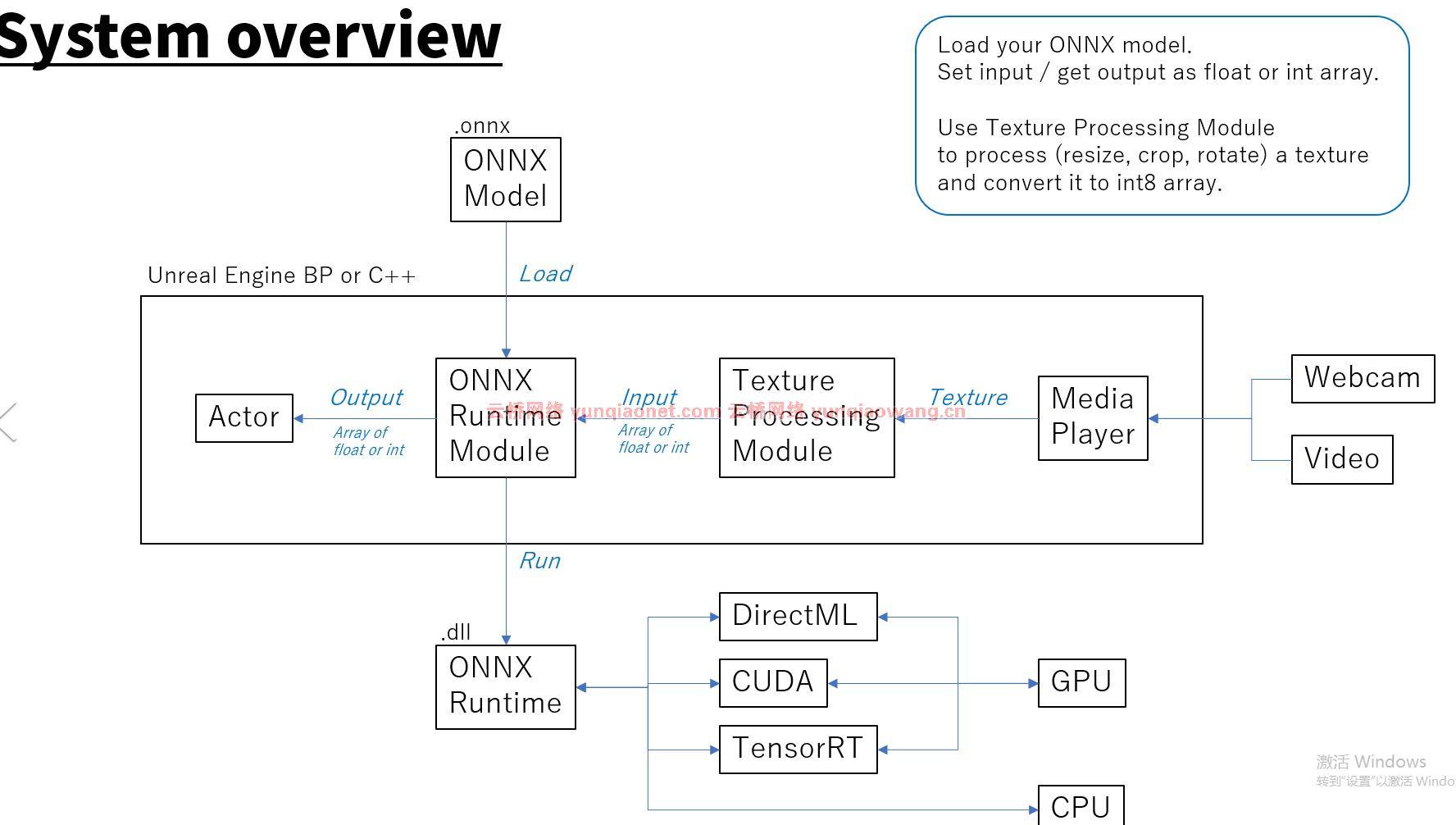

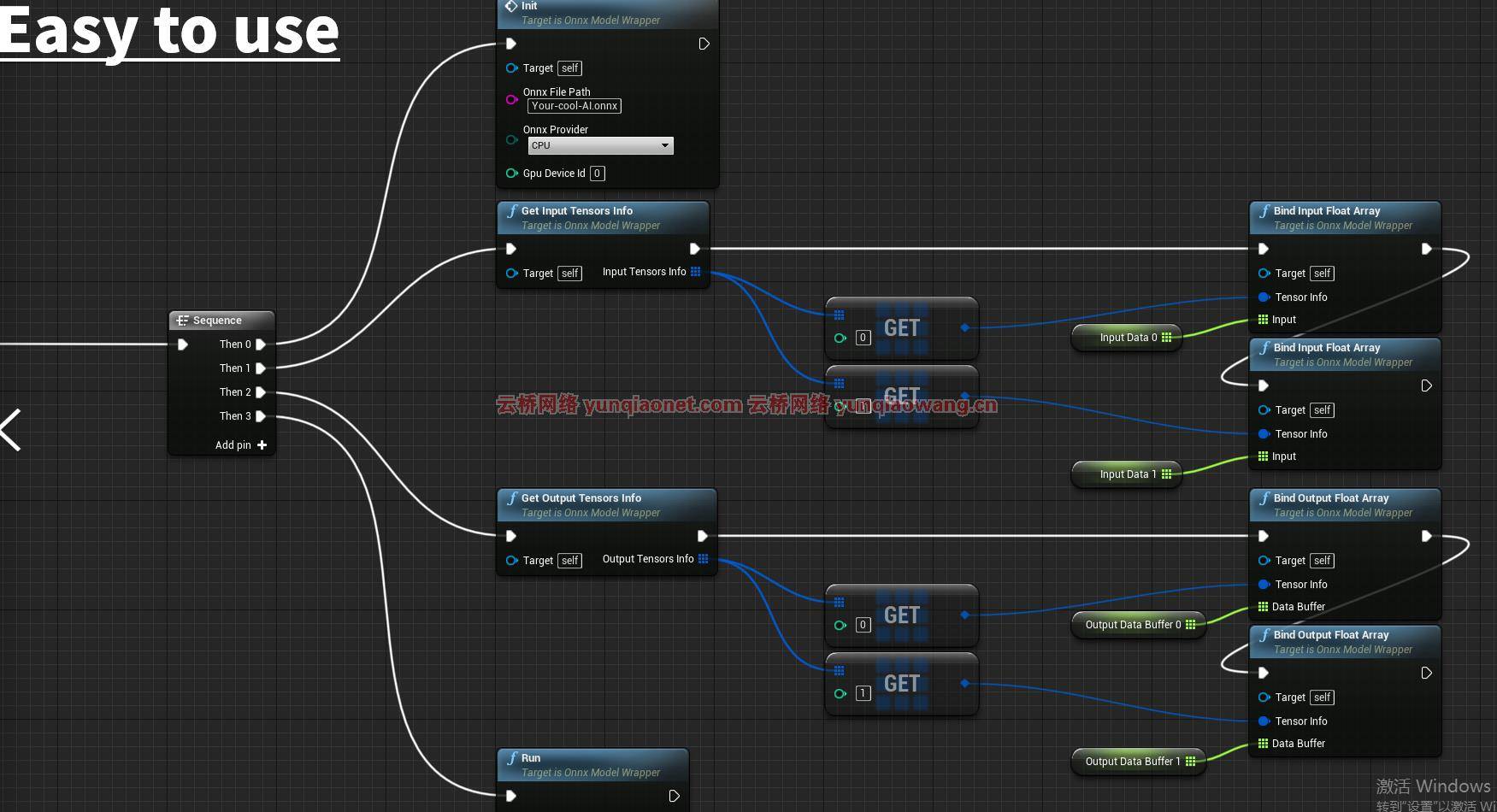

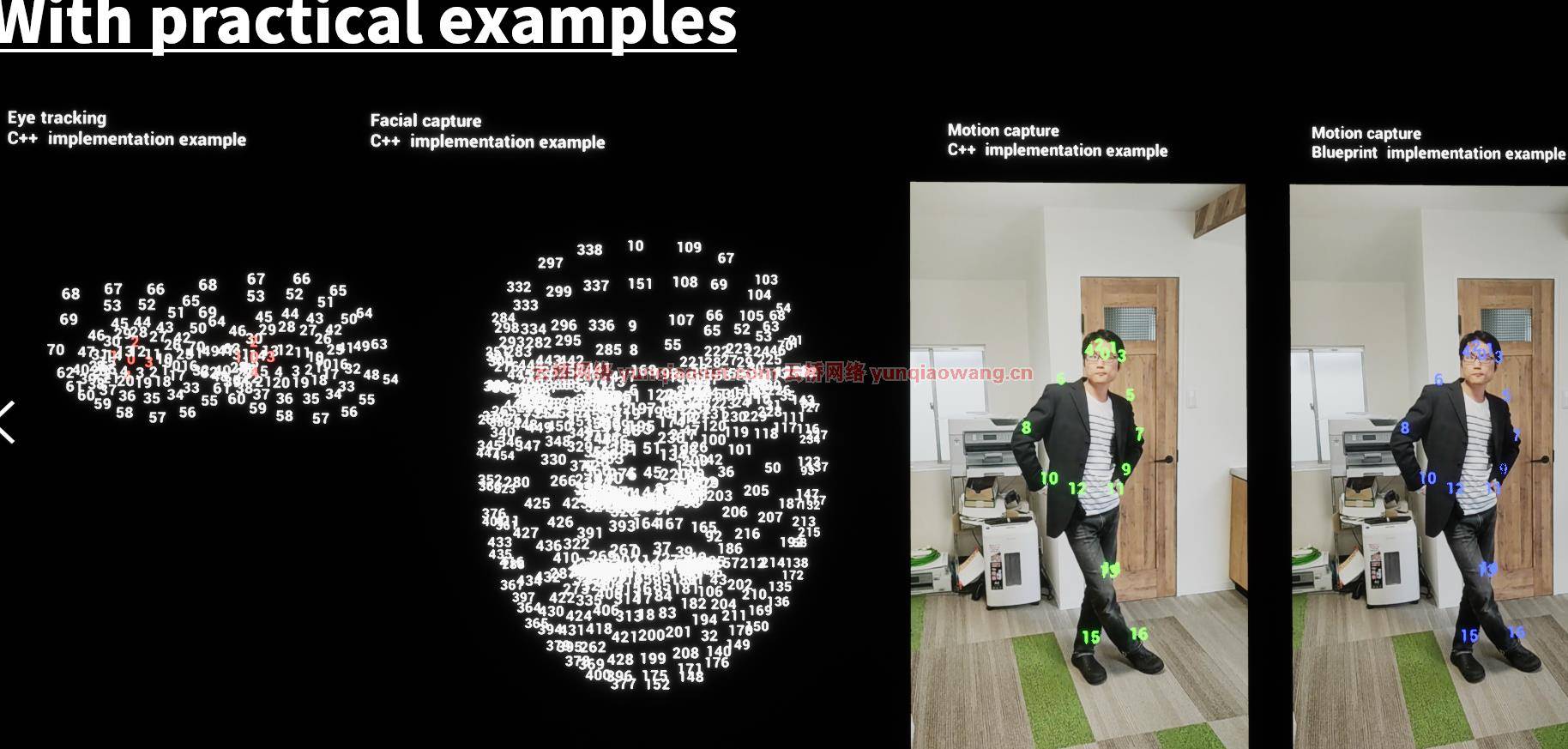

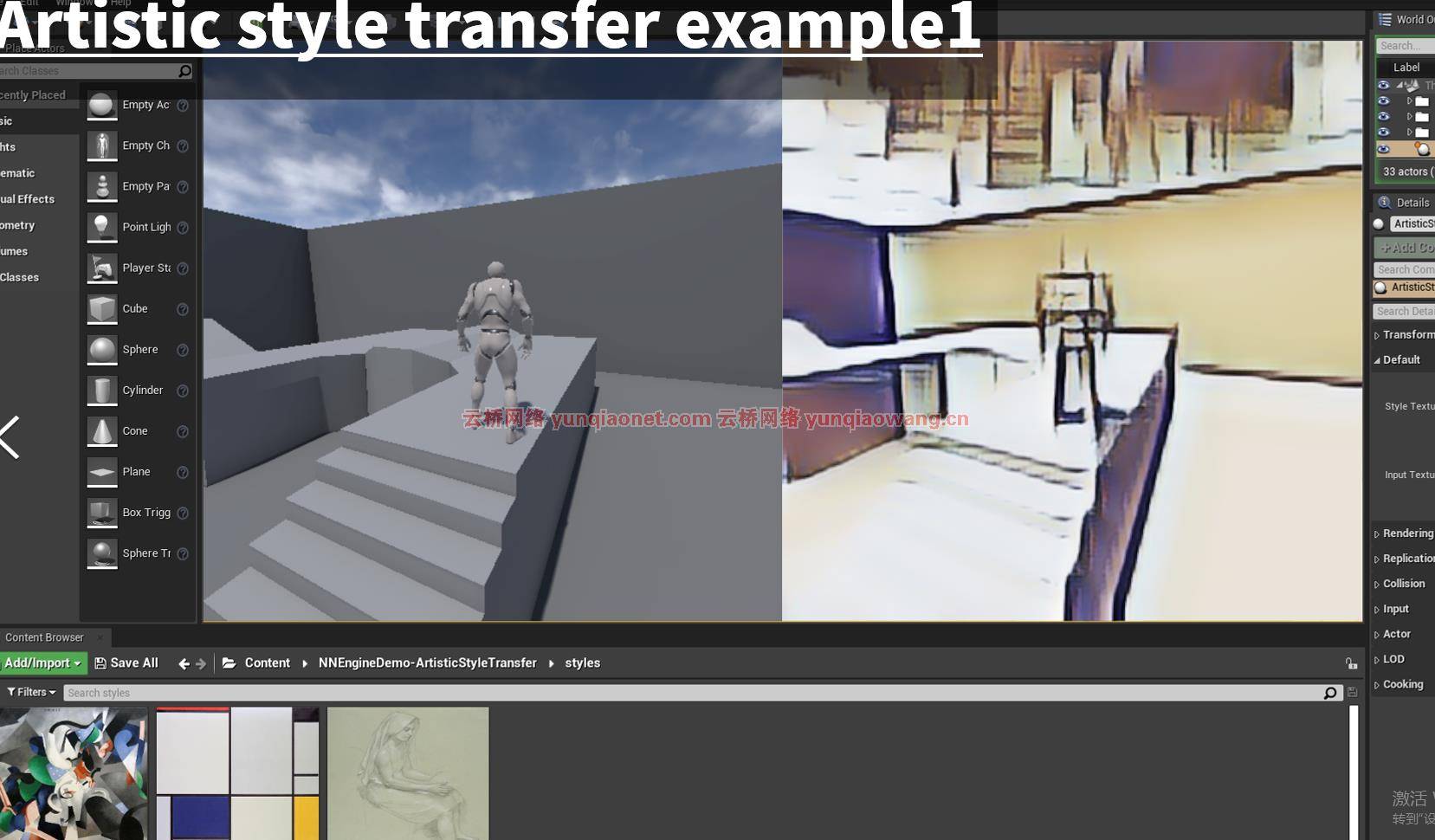

NNEngine – Neural Network Engine v1.5 (4.27, 5.0) 使用ONNX运行时本地库从BP和C++进行简单、加速的ML推理。通过简单地调用几个蓝图节点,可以加载运行前沿AI。

该插件支持ONNX(开放神经网络交换),这是一种广泛使用的开源机器学习模型格式。性能是我们首先要考虑的。

该插件支持运行时的模型优化和各种硬件上的GPU加速,以及该插件本身的优化。

特点:

在运行时加载ONNX模型。加载时自动优化模型。

运行ONNX模型。

(在Windows上)支持在支持DirectX 12的GPU上通过DirectML进行硬件加速。

(在Windows和Ubuntu上)支持在支持的NVIDIA GPUs上通过CUDA和TensorRT进行硬件加速。

(在Windows上)获取系统上可用的GPU名称列表。

处理(调整大小,裁剪,旋转)UTexture并将其转换为int8数组。

代码模块:

OnnxRuntime(运行时)

纹理处理(运行时)

CustomizedOpenCV(运行时)

DirectXUtility(运行时)

蓝图数量:3

C++类的数量:7个以上

网络复制:否

支持的开发平台:Windows 10 64位、Ubuntu 18.04.6桌面64位

支持的目标构建平台:Windows 10 64位、Ubuntu 18.04.6桌面64位

重要/附加说明:

演示项目1是作为C++项目分发的。需要安装Visual Studio才能编译。

1、登录后,打赏30元成为VIP会员,全站资源免费获取!

2、资源默认为百度网盘链接,请用浏览器打开输入提取码不要有多余空格,如无法获取 请联系微信 yunqiaonet 补发。

3、分卷压缩包资源 需全部下载后解压第一个压缩包即可,下载过程不要强制中断 建议用winrar解压或360解压缩软件解压!

4、云桥网络平台所发布资源仅供用户自学自用,用户需以学习为目的,按需下载,严禁批量采集搬运共享资源等行为,望知悉!!!

5、云桥网络-CG数字艺术学习与资源分享平台,感谢您的赞赏与支持!平台所收取打赏费用仅作为平台服务器租赁及人员维护资金 费用不为素材本身费用,望理解知悉!